Une brève histoire de la naissance des tests d’intelligence

L’intelligence: un construit théorique et une variable latente

L’intelligence est depuis longtemps un sujet d’analyse et de controverse au sein du champ scientifique. Plus encore, le QI, mesure phare des tests d’intelligence, est devenue une notion utilisée couramment par le grand public, à tort et à travers. Le but de cet article sera donc de clarifier la notion de QI et les tests d’intelligence en s’intéressant à leur histoire et au contexte de leur naissance.1

La psychologie, qui s’est emparée de cette question épineuse, est traversée par de nombreux courants qui tentent d’une part de définir l’intelligence, et d’autre part de la mesurer à l’aide de différents outils. La psychologie différentielle, qui concerne l’étude des différences psychologiques entre les individus, est la branche de la psychologie à avoir le mieux étudié l’intelligence à travers notamment des modèles statistiques poussés.

Difficilement définissable, l’intelligence est avant tout un concept, un construit théorique, expliquant une multitude d’aspects du comportement humain, et qui peut prendre plusieurs formes en fonction des théories que l’on choisit de suivre. Cette grande malléabilité du concept est une de ses premières limites. L’intelligence n’est « qu’un » construit théorique, qui ne possède aucun grand consensus scientifique sur sa définition exacte.

L’intelligence est donc conçue comme une variable latente, c’est à dire qu’elle n’est pas observable directement. Les différentes épreuves qui composent les tests d’intelligence mesurent, ou du moins tentent de mesurer des variables manifestes, qui seraient directement observables – la mémoire à court terme en fait par exemple partie. Ce sont les différentes variables manifestes mesurées par les épreuves des tests d’intelligence qui permettent donc d’estimer une variable latente, commune à toutes les épreuves, mais qui n’est pas directement mesurable : l’intelligence.

Cette dernière, avant d’être présentée comme une mesure, est avant tout une construction socio-culturelle. Les définitions de l’intelligence et d’un comportement intelligent varient selon les cultures. Dans un monde parfait, il faudrait donc que chaque culture développe son propre test d’intelligence, ce qui est loin d’être le cas à l’heure actuelle, les différentes tests d’intelligence s’inscrivant tous dans le contexte socio-culturel des pays WEIRD (Western Educated Industrialised Rich Democratic), où l’intelligence est conçue comme une capacité de raisonnement abstrait, de compréhension verbale et écrite ainsi qu’une bonne adaptation à l’environnement.

Le Quotient Intellectuel (QI), objet de nombreux fantasmes, est l’un des indicateurs les plus sérieux qui tente d’estimer l’intelligence, ou du moins une certaine intelligence, dans un contexte socio-culturel occidental. Dans cet article nous retracerons un bref historique de la naissance des tests d’intelligence et en particulier du test de QI afin de comprendre les différents modèles de définition de l’intelligence.

Alfred Binet et le premier test d’intelligence

Le français Alfred Binet (1857-1911) est souvent considéré comme l’un des psychologues et pédagogues les plus visionnaires de son temps, bien qu’il n’ait jamais occupé de poste universitaire. Les travaux de Binet, considérés comme étant à l’origine des tests d’intelligence actuels, sont d’abord plutôt passés sous les radars en France pour trouver un certain écho aux Etats-Unis.

Avant Binet, l’étude de l’intelligence était dominée par une approche essentiellement empiriste, associationniste et réductionniste. L’intelligence était perçue comme une somme de phénomènes sensori-moteurs élémentaires. Binet se détache de cette vision, en postulant que l’intelligence fait partie de la personnalité dans sa totalité. Le terme recouvre pour lui des composantes cognitives, mais aussi intellectuelles, incluant les émotions et la volonté. Le psychologue crée la première échelle d’intelligence en 1905 avec Théodore Simon afin de prédire les performances intellectuelles d’enfants.

Ce test de 1905 est avant tout conçu pour diagnostiquer l’« arriération mentale », selon les termes de l’époque, et donc pour identifier les enfants en déficience intellectuelle afin de pouvoir les placer en éducation spécialisée. Le test de Binet-Simon s’inscrit dans un contexte de mise en place de l’école obligatoire en France, et des difficultés rencontrées par les enseignants pour détecter correctement les cas d’enfants nécessitant une éducation spécialisée.

Ce premier test d’intelligence est en réalité plutôt un test d’ « inintelligence », le point de départ du test étant le diagnostic d’« arriération mentale ». A travers trois composantes complémentaires – la méthode psychologique, pédagogique et médicale (Binet est par ailleurs l’inventeur du carnet médical scolaire en France) – le questionnaire de 30 questions (dont une grande partie est encore utilisée aujourd’hui) détermine si l’enfant est « normal » ou s’il est « arriéré ». Au sein de cette dernière catégorie, Binet distingue trois niveaux de déficience : les idiots, les imbéciles, et les débiles.

En 1908, Binet et Simon proposent une deuxième version de leur test en supprimant la mention de ces trois niveaux de déficience pour y préférer une structuration des résultats par rapport à la tranche d’âge à laquelle appartient l’enfant. Les questions y sont hiérarchisées en fonction de la réussite-échec aux différents âges : sur leur échantillon test, il faut donc par exemple que 50 à 60% des enfants de 6 ans réussissent une question pour que celle-ci soit déclarée comme adaptée au niveau d’un enfant de cet âge-là. Ainsi, des enfants plus jeunes doivent logiquement échouer à la plupart des questions réussies par une majorité des enfants de 6 ans, et vice-versa.

On retrouve dans la théorie de Binet plusieurs éléments intéressants : tout d’abord, ce dernier conçoit son test comme une mesure d’évaluation entre les enfants, et non pas comme un outil objectif « en soi », puisque le niveau intellectuel est défini en fonction du niveau global des enfants. L’évaluation a donc un caractère construit et non purement scientifique. Pour cette raison, Binet se refusera toujours à parler d’« âge mental », y préférant le terme de « niveau intellectuel », moins complexe à identifier, car englobant une quantité de processus plus limitée.

A la mort de Binet en 1911, William Stern reprend ses travaux et développe le quotient intellectuel, qui établit le rapport entre l’âge mental et l’âge chronologique, rapport que Binet avait toujours refusé de faire. L’utilisation du QI demeure véritablement une abréaction par rapport aux idées originelles de Binet. Pour calculer le QI, Stern divise le résultat obtenu au test par l’âge de l’enfant (en mois), et Lewis Terman vient en faciliter la lecture en le multipliant par 100. Aujourd’hui, la mesure de 100 est d’ailleurs toujours utilisée comme mesure moyenne du QI bien que ce rapport âge mental/âge chronologique ait été abandonné dans la mesure du QI.

Ce premier quotient intellectuel présentait plusieurs problèmes. D’abord, il était impossible de mesurer l’évolution du QI de l’enfant au fil de sa croissance, et ensuite, la mesure n’était plus pertinente après 13 ans et donc inexploitable pour des adultes. Finalement, la création de ce QI constituait une véritable trahison par rapport à l’esprit de Binet, ce dernier estimant qu’il était trop aventureux de prétendre réussir à calculer l’âge mental d’un enfant. Cette première version du QI disparaîtra en 1939 avec la création du test de Wechsler.

Exportation du test de Binet-Simon aux Etats-Unis et institutionnalisation du « testing »

En 1910, le psychologue américain Goddard découvre les travaux de Binet et Simon et décide de les adapter au contexte américain. Goddard, qui sera par ailleurs à l’origine des premières lois sur l’enseignement spécialisé aux Etats-Unis, emploie ce test dans le même objectif d’identification des élèves en difficulté développé par Binet.

Parallèlement à ses travaux sur le système scolaire, Goddard participe à l’évaluation systématique, grâce au test inspiré de Binet-Simon, des migrants arrivant par bateau aux Etats-Unis, tout échec conduisant à un renvoi systématique des migrants dans leurs pays d’origine. Le psychologue, ouvertement eugéniste, en arrive à la conclusion que la majorité des migrants sont déficients intellectuellement, il note par exemple que 87% des Russes seraient débiles, et tombe ainsi dans le piège de la négation des aspects socio-culturels et linguistiques, jouant pourtant un rôle central dans un test d’intelligence comme celui de Binet-Simon.

En 1915, Robert Yerks, chef du groupe de psychologues de l’armée américaine, décide d’utiliser massivement des tests d’intelligence adaptés de ceux de Binet dans l’armée américaine. 1.7 million de recrues passeront ce test, décliné en deux versions. Tandis que le Test Army Alpha concerne ceux dont la compréhension de la langue est suffisamment bonne pour comprendre les consignes, le Test Army Bêta, est développé pour ceux ne pouvant pas lire, chose fréquente à l’époque. Le test de Yerks, qu’il soit administré de façon verbale ou écrite, représente le test d’intelligence le plus répandu jusqu’à la création des échelles de Wechsler en 1939.

Le premier modèle de l’intelligence: Charles Spearman et le facteur g

Parallèlement au développement de ces tests d’intelligence initié par Binet, des chercheurs en psychologie vont développer des modèles statistiques poussés pour essayer de comprendre les bases de l’intelligence. La même année que celle de la mise au point par Binet du premier test d’intelligence, le psychologue anglais Charles Spearman développe le premier modèle sérieux de l’intelligence, impliquant une notion clé qui va radicalement modifier l’étude de la psychologie différentielle : le facteur g.

Charles Spearman a travaillé essentiellement avec des enfants sains en utilisant des tests assez hétérogènes, impliquant différents domaines (verbal, auditif, écrit, sensori-moteur etc.). Lui vient alors l’idée de procéder à un calcul de corrélation entre les résultats des différents tests administrés en développant une nouvelle technique statistique: l’analyse factorielle. Quel n’est pas l’étonnement de Spearman lorsqu’il découvre, à la suite de ce calcul de corrélation poussé, que toutes les épreuves corrèlent entre elles sur un seul facteur.

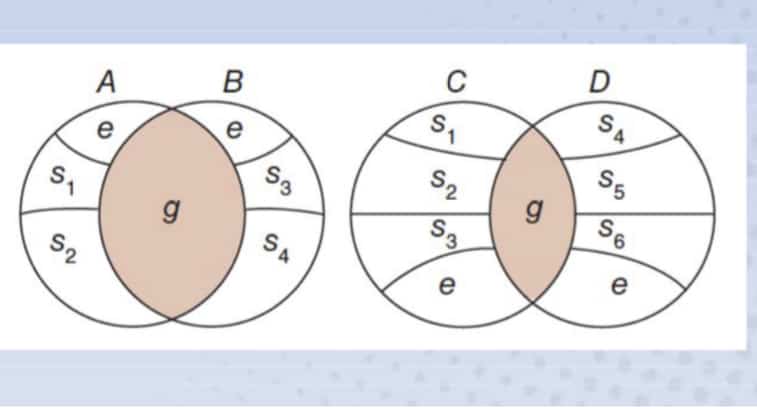

Ces résultats vont le pousser à développer un premier modèle théorique de l’intelligence identifiant un double facteur à l’origine de l’intelligence : le facteur g – le facteur général d’intelligence, et un facteur s – un facteur spécifique propre à chaque test. Pour Spearman, la part de variance commune entre les épreuves est issue d’un même facteur, le facteur g. Ainsi, toutes les épreuves corrèlent positivement parce qu’elles possèdent toutes le facteur g. Derrière cette hypothèse, on retrouve donc l’idée que l’intelligence pourrait bel et bien être liée à un seul et unique facteur, influant tout type d’épreuve de raisonnement.

Thurstone et la Théorie des Aptitudes Mentales Primaires

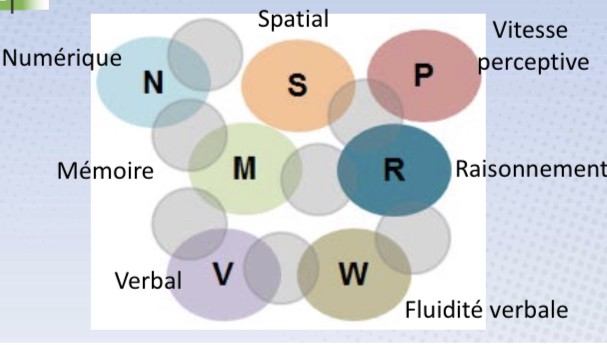

Cette hypothèse de l’existence d’un facteur général de l’intelligence va être critiquée, notamment par Louis Thurstone, psychologue américain, qui va développer en 1936 un nouveau modèle d’explication de l’intelligence : la théorie des aptitudes mentales primaires. Cette théorie, basée également sur un total important de batteries de tests administrés à des étudiants, va conclure à l’existence de 7 ou 8 aptitudes mentales primaires, des formes d’intelligences relativement indépendantes les unes des autres et qui regroupent un certain nombre de variables manifestes.

Pour Thurstone, cette indépendance sous-entend qu’il faut évaluer l’individu sur chacun des facteurs de groupe spécifiquement, et donc qu’il faut développer un test d’intelligence comprenant un nombre très important d’épreuves. Cette vision multifactorielle de l’intelligence s’oppose directement à la lecture uni factorielle de Spearman. Thurstone rejette dans un premier temps l’existence d’un facteur g, avant de reconnaitre vers la fin de sa vie une possible existence d’un tel facteur, en observant notamment une certaine corrélation entre ses différents facteurs de groupe.

Le modèle de Cattell : Intelligence fluide (Gf) – Intelligence cristallisée (Gc)

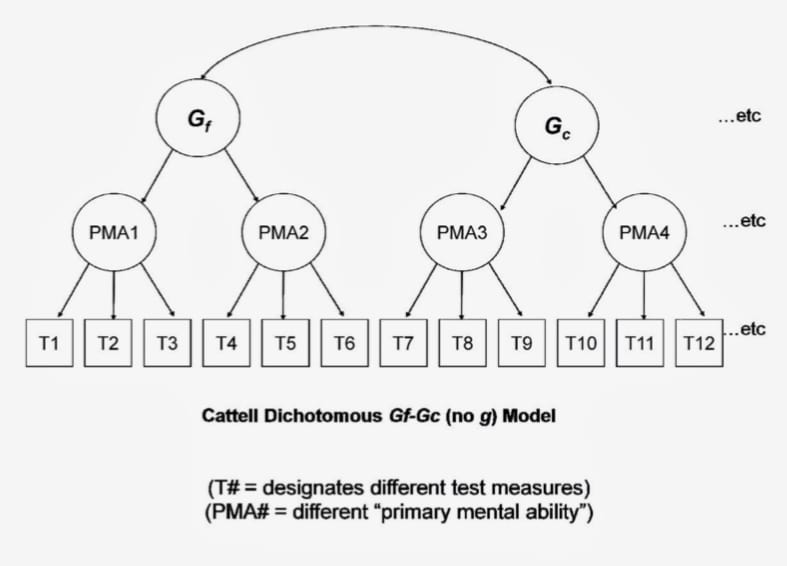

Cattell va utiliser la même méthodologie que Spearman et Thurstone, à quelques différences près. Il va constater que le résultat de l’analyse statistique crée deux corrélations principales, séparant ainsi les épreuves en deux « paquets », autrement dit en deux facteurs. Cattell identifie d’une part le facteur Gf, l’intelligence fluide, qui concerne essentiellement les épreuves de raisonnement et où l’influence de la culture et de l’éducation sont minimisées. L’intelligence fluide est donc généralement associée à une capacité générale de raisonner, elle trouve son support essentiellement dans la biologie et la génétique humaine.

D’autre part, Cattell observe le facteur Gc, l’intelligence cristallisée, qui concerne essentiellement des épreuves verbales et où s’exprime principalement l’influence culturelle, l’éducation, l’apport biologique y étant donc minime. Dans ce modèle, Gc est donc généralement associé à une capacité d’utiliser les compétences acquises auparavant, notamment à l’école. Avec Gf et Gc, Cattell sépare donc l’intelligence acquise, Gc, de l’intelligence biologique/innée, Gf.

Gf et Gc influencent directement les facteurs de groupe identifiés par Thurstone (PMA dans le graphique). Source: Thierry Lecerf.

Le psychologue américain John Horn étendra par la suite ce modèle de Cattell en rajoutant des catégories supplémentaires à Gf et Gc, notamment avec l’existence d’une mémoire à long terme. Les visions de Cattell et Horn diffèrent cependant sur un point : l’existence du facteur g. Si Cattell y semble plutôt favorable, Horn rejette fermement son existence.

Le modèle CHC, où la fusion entre Thurstone, Spearman et le modèle Cattell-Horn

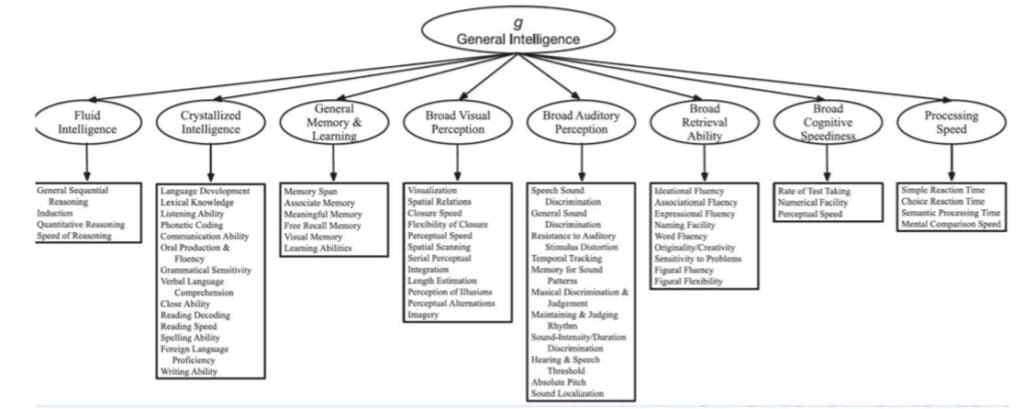

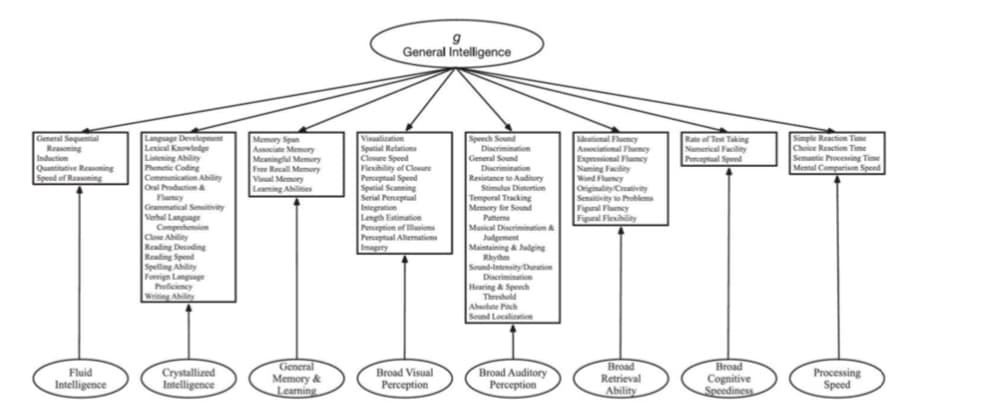

En réaction à cette controverse Spearman et Thurstone, plusieurs psychologues vont développer des modèles hiérarchiques, cumulant donc le facteur g de Spearman et les facteurs de groupes de Thurstone et de Cattell et Horn. On retrouve parmi ces nombreux modèles celui du psychologue américain John Carroll, issu d’un des travaux empiriques les plus sérieux dans le domaine de la psychologie de l’intelligence. En effet, Carroll, après avoir effectué une méta-analyse de toutes les études issues du domaine de la psychologie de l’intelligence entre 1930 et 1985, (soit un total de 130 000 participants !), développe l’un des premiers modèles hiérarchiques de l’intelligence.

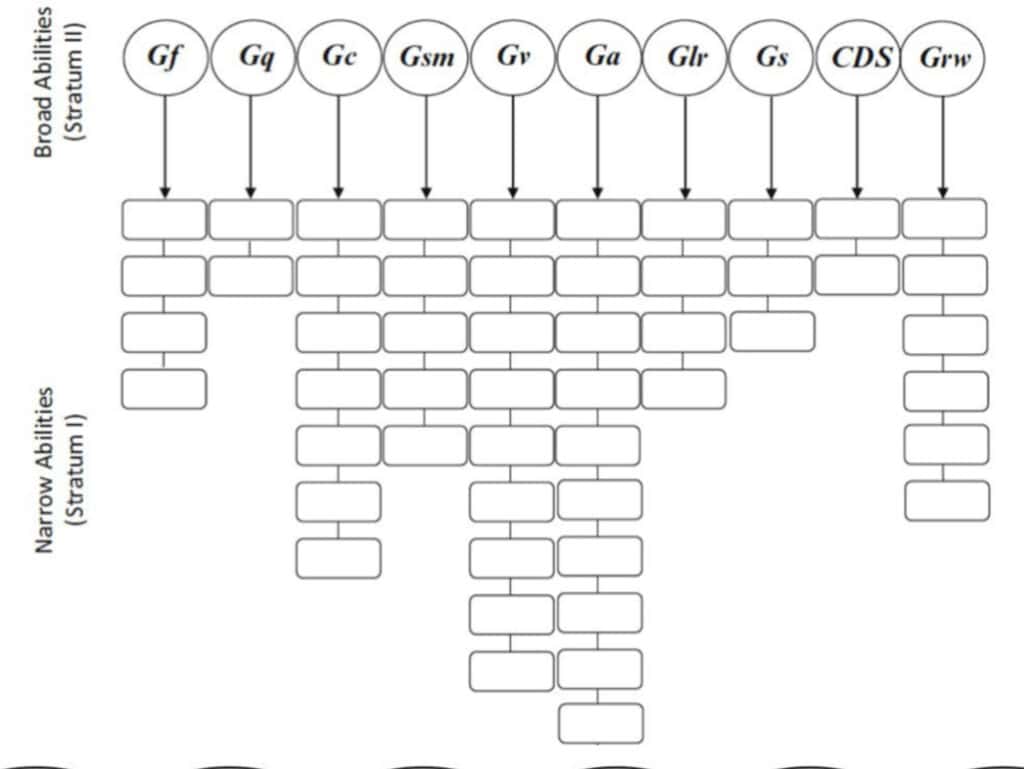

Ce modèle hiérarchique vient directement soutenir les modèles de Spearman, Thurstone et Cattell-Horn. Le facteur g, au sommet, est présent chez chacun des facteurs de groupe à des niveaux différents, mais n’a aucune influence directe sur une épreuve. Par ailleurs, on retrouve dans les facteurs de groupe l’existence de Gf, Gc, mais aussi les différents facteurs supplémentaires proposés par Horn.

La démonstration statistique de Carroll réside essentiellement dans le fait qu’il identifie d’une part l’existence de ces facteurs de groupe, et d’autre part, que ces facteurs de groupes corrèlent à un degré divers avec un facteur commun, le facteur g. Il va par ailleurs considérer que la relation entre Gf et g serait quasiment parfaite (soit une corrélation atteignant presque 1), estimant ainsi qu’en mesurant Gf on mesure g. Dans le tableau issu de ce travail important, plus les facteurs de groupe sont situés vers la droite et moins la part du facteur g y est importante.

Il est à noter cependant, que si l’histoire a surtout retenu ce modèle hiérarchique, il se trouve que plus tard dans sa vie, Carroll va développer un autre modèle, bi-factoriel cette fois-ci, où le facteur g et les facteurs de groupe sont indépendants. G influence donc cette fois-ci directement les épreuves. A l’heure actuelle l’essentiel des débats traversant la psychologie différentielle concerne surtout cette opposition, soulevée par Carroll, entre modèle hiérarchique et modèle bi-factoriel, le facteur g ayant une signification différente selon le modèle choisi.

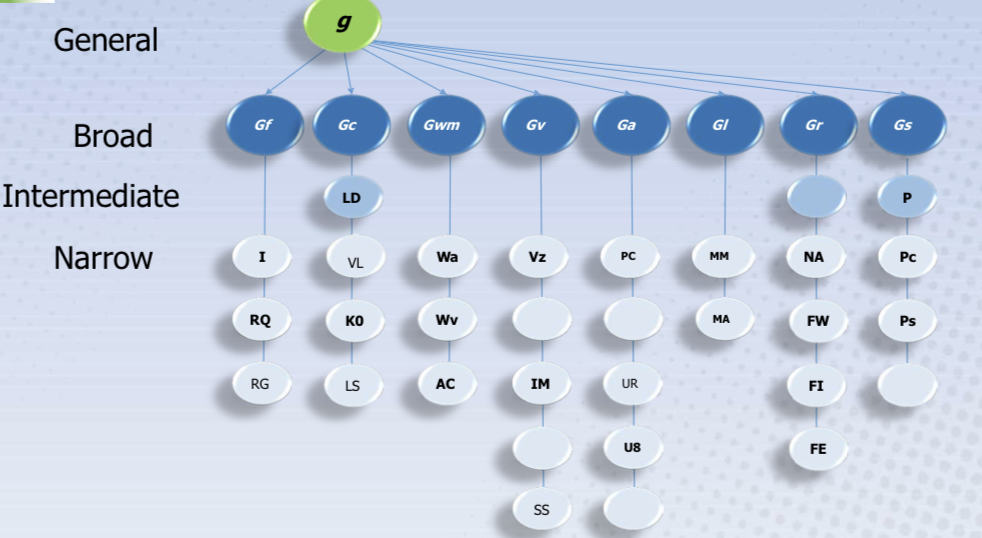

Issu directement des travaux de Carroll, un dernier modèle va faire son apparition à partir de 1999. Ce modèle représente le consensus actuel dans l’interprétation des tests psychologiques en matière d’intelligence, mais également dans la structure des tests d’intelligence, comme les échelles de Wechsler. Le modèle Cattell-Horn-Carroll (CHC), dont la version la plus récente date de 2018, propose une organisation plutôt hiérarchique comprenant environ 10 facteurs de groupe et près de 70 facteurs spécifiques. Selon les modèles, le facteur g est présent ou non. Parmi les facteurs de groupes, on retrouve notamment Gf et Gc.

Les échelles de Wechsler et la naissance des tests d’intelligence modernes

De nombreux tests d’intelligence ont été développés dans le sillage du test Binet-Simon. Les tests développés dès 1917 par David Wechsler, qui travaille dans l’armée américaine et fait passer un nombre important de tests Army Alpha et Army Beta, se situent dans cet héritage et combinent des épreuves variées recrutant différents types d’habilités. Les versions finales de ses tests d’intelligence, qui laissent transparaître une perception de cette dernière comme une capacité globale incluant des éléments intellectuels comme non intellectuels et également une capacité d’adaptation à son environnement, sont adoptées en 1939.

Les tests de Wechsler, appelés « échelles de Wechsler », constituent l’essentiel des tests d’intelligence utilisés aujourd’hui. Ces échelles ont donné naissance aux trois tests d’intelligence les plus utilisées aujourd’hui en psychologie:

- Le WPPSI, qui concerne les jeunes enfants de moins de 6 ans, et dont la 4ème version date de 2012.

- Le WISC, qui concerne les enfants dès 6 ans, et dont la 5ème version date de 2014.

- Le WAIS, qui concerne les adultes et dont la 4ème version date de 2011.

Le WISC est aujourd’hui le test d’intelligence le plus administré. Il est composé de 7 épreuves, dont le score pondéré donne le QI total, qui permet d’estimer le niveau de fonctionnement cognitif général des enfants, une fois couplé à des observations cliniques du comportement et à l’anamnèse de l’enfant. L’échelle totale comprend 5 indices principaux qui rendent compte du niveau de performance de l’enfant : la compréhension verbale, le visuo-spatial, le raisonnement fluide, la mémoire de travail et la vitesse de traitement. Assez fréquemment ces tests sont mis à jour, pour que le score moyen de la population atteigne 100. Un test d’intelligence reconnu comme le WISC doit obligatoirement être administré par un professionnel de santé mentale (ex. psychologue ou psychiatre) formé.

Le QI, bien qu’il ne soit pas parfait, est l’un des meilleurs indicateurs des performances scolaires et professionnelles. C’est également une aide précieuse au diagnostic de certaines pathologies, comme la déficience intellectuelle (un QI en-dessous de 75 est un des critères essentiels au diagnostic). On sait que le QI total ne correspond sans doute pas complètement au facteur g, et donc à une forme supposée d’intelligence (l’intelligence restant un construit théorique, ne l’oublions pas), et la prudence est de mise lorsque l’on utilise cet outil, les projections pouvant s’avérer incorrectes pour un nombre non-négligeable d’enfants.

Pour de nombreux psychologues spécialisés en psychologie différentielle, les tests d’intelligence ne devraient être réservés qu’à un but : détecter les cas d’enfants ou d’adultes présentant des difficultés scolaires afin de leur proposer un accompagnement adapté. Cet objectif rejoint parfaitement la vision du fondateur du premier test d’intelligence, Alfred Binet, si lucide sur les dérives potentielles du développement d’une telle mesure.

- L’intégralité de cet article est basé sur le cours de psychologie différentielle de Thierry Lecerf, maitre de conférence à l’Université de Lausanne ↩︎